Ort - Netzwerk

Ort - Netzwerk

Kommunikation ist ein Grundbedürfnis für Menschen und die Voraussetzung für Intelligenz1.

Das Material der Kommunikation ist die Information. Kommunikation ist der Austausch von Information, der im Zeitalter der Computernetzwerke zunehmend automatisiert gehandhabt wird. Damit kann es sein das Information sich zunehmend verselbständigt und nicht mehr vom Informationsgenerator kontrolliert werden kann.

Wenn A mit B was vereinbaren will und aber zu weit entfernt von B ist, kann er 1. zu ihm gehen, 2. lauter schreien oder 3. jemanden oder irgendwas zwischen ihnen benutzen um die Information weiterzureichen. Das letztere wird ''Vernetzung'' genannt und der Weg der Information das ''Routing''2.Die Idee des Netzwerkes ist damit sicherlich älter als die Telekommunikation selbst.

Die Definitionen, wie dieser Informationsaustausch basiert benötigt Vereinbarungen, den ''Kommunikations-Protokollen''. Diese sind zum Großteil in den Kommunikationsgeräten implementiert und offenbaren sich nur durch die Bedienungselemente und Benutzerführung. Da Informationsaustausch auch Kontrolle und Macht bedeutet, vermischt sich Politik mit den technischen Anforderungen bei deren Festlegung.

Das Netz der Netze

Wenn es auch als Experiment begann3 und seine Jugend ein Spielplatz für Akademiker und Exzentriker war, haben die aktuellen Entwicklungen das weltweite Netz von Computer-Netzwerken - das ''Internet'' - in eine schnell wachsende und dauernd verändernde verteilte Gemeinschaft von Computerbenutzern und Informations-Verteiler transformiert. Heutzutage findet man im Internet Benutzer von praktisch allen Nationen und Überzeugungen, von seriösen zu frivolen Individualisten und von kommerziellen zu gemeinnützigen Unternehmungen.

Die Anforderung, daß das Internet Teilausfälle überleben muß, war auschlaggebend für die Festlegung der Eigenschaft, daß jeder Computer sich mit jedem anderem im Netz verbinden kann4, damit bei Ausfall eines Teiles des Netzwerks das Restliche trotzdem funktionstauglich bleibt. Es muß nur mindestens eine Verbindung zwischen Ihnen (Route) geben. Die Kommunikation passiert prinzipiell zwischen zwei Computer die selbst dafür sorgen müssen, daß die Information in Form von Datenpacketen mittels des Internet-Protokolls (IP) vollständig ankommt5. Damit ist jeder Computer im Internet gleichgestellt und die Information kann inhaltlich nicht beschränkt werden. Erst durch zusätzliche Sicherheitsmaßnahmen werden diese Eigenschaften eingeschränkt (z.B.: Firewall).

So wurden auch neue auf dem grundlegenden IP basierende Protokolle (wie z.B: HTTP, das HyperText Transfer Protocol) entwickelt. Dies kann jeder Teilnehmer tun, ohne die Funktion des Gesamten zu stören. Es muß ''nur'' intern eine Einigung auf ein Protokoll stattfinden und für eine Verbreitung dieses sich durchsetzen. Damit wurde eine dynamische Entwicklung ermöglicht, welche als Selbstorganisation betrachtet werden kann. Nicht nur das sich die Teilnehmer selbst organisieren, sondern auch das die Mechanismen der Organisation selbst bestimmt wurden und diese Entscheidungen zunehmends automatisiert werden.

Wird durch Automatisierung Entscheidungen zunehmends vom Benutzer unabhängig, kann ein System, unter der Voraussetzung daß es über genügend lebenserhaltende Mittel verfügt, sich verselbständigen.

Wer regiert das Internet ?

Das Internet besitzt keine Verfassung, keine Regierung und kein Parlament, nicht einmal ein Rechtssystem. Verbindliche Regelwerke wie das Internet Protocol beziehen ihre Anerkennung allein aus der Zustimmung der Nutzer bzw. ihrer Netzadministratoren. Paradoxerweise ist es gerade die Architektur des Internet, die verantwortlich für diese Dezentralisierung von Entscheidungsverhältnissen ist. Je erfolgreicher das Projekt globaler Konnektivität, desto unkontrollierbarer gestalten sich dessen Rückwirkungen auf die Netzarchitektur.

Organisationsform - Sebstorganisation ?

Je weiter sich das Internet ausdehnt, desto schwieriger gestaltet sich die Bewältigung von Krisen, die durch sein Wachstum verursacht werden. Die Dezentralität und Offenheit des Netzes ist nämlich zugleich Grund seines Erfolges, wie auch erhebliches Hindernis bei dem Versuch, neue Techniken netzweit durchzusetzen.

Um 1990 schien das Netz an zwei betriebswichtigen Stellen gleichzeitig unter Druck zu geraten. Engpässe zeichneten sich zum einen in der numerischen Adressierungskapazität ab. Diese entscheidet über die Zahl möglicher Netzknoten und Nutzer, die eine weltweit eindeutige Identität im Internet erhalten können - und damit folglich über den maximalen Umfang, den das Netz erreichen kann.

Wachstumsgrenzen zeigten sich zum anderen im Routingbereich7. Die Zahl der Wege im Netz wuchs schneller als die Kapazität der Rechner zur Kalkulation derselben. Die Speicher- und Rechenkapazität der Router aber bestimmten letztlich die Anzahl erreichbarer Objekte im Netz, d.h. Netzknoten oder Örtlichkeiten, zu denen Datenrouten ermittelt werden können.

Auch das Problem der ''routing explosion'' hängt mit dem Wachstum des Internet nur mittelbar zusammen. Dem Adreßraum mangelte es an einer Ordnung, die die Zunahme der Datenrouten von jener der Örtlichkeiten entkoppelte8. Dabei hatte die Struktur des Adreßraums bei der Entwicklung von IPv4 keine große Rolle gespielt. Solange das Internet klein war und nur einen ''backbone'' besaß, der faktisch den einzigen Transitweg für alle Datenpakete bildete, interessierte die Effizienz des Adressierungsverfahrens ebensowenig wie seine ''Routingfreundlichkeit''. Adressen dienten vorrangig zur Identifikation, nicht aber zur Lokalisierung von Rechnern. Bis 1993/1994 wurden IP Adressen tatsächlich sequentiell, das heißt in der Reihenfolge der Antragsteller, ohne Rücksicht auf die geographische oder topologische Position der Netze vergeben

Die miteinander verschränkten Skalierungsprobleme des Internet steckten den Rahmen für die Entfaltung widerstreitender Lösungsvorstellungen ab, die, gewollt oder ungewollt, zwei zentrale Regierungsfragen im Netz aufwarfen. Die eine galt der Architektur des Internet: Sind die aktuellen Skalierungsprobleme als Indiz dafür zu werten, daß das Projekt globaler Konnektivität eine von Grund auf erneuerte Netzorganisation erfordert oder bedarf es lediglich einer verbesserten Implementierung seiner Prinzipien? Die andere thematisierte die Machtverteilung in der IETF (siehe unten): Und wem obliegt es, darüber zu entscheiden?

Techniken des Regierens im Netz

Über die Güte technischer Ideen soll nach Überzeugung der Community nicht mittels Abstimmung, sondern durch den empirischen Nachweis ihrer Machbarkeit entschieden werden - in der Sprache der Techniker: durch running code. Running code bezeichnet Software, die sich im Testlauf als funktionstüchtig erweist. Mehrere ''genetisch'' voneinander unabhängige Implementationen, die die Interoperabilität von Programmen belegen, sind Voraussetzung dafür, daß technische Entwürfe als Internet Standards anerkannt werden.9

Running code verkörpert ein legendenumranktes Konsensbildungsverfahren und zugleich das wohl wichtigste Merkmal, durch das sich die IETF10 von anderen Standardisierungsorganisationen unterschieden wissen will:

''running code'' das Ideal eines rein technischen Diskurses, dessen Resultat in vernünftigen, robusten und vor allem nützlichen Standards besteht. Sei der Entscheidungsprozeß in den offiziellen Standardisierungsgremien von der Politik dominiert, regiere in der IETF die ''technische Realität'' des Machbaren. Der zentrale Wahlspruch der IETF, formuliert 1992 von einem der ''Väter'' des Netzes, spitzt die Differenz zwischen diesen beiden Techniken des Regierens voller Pathos zu:

''We reject presidents, kings and voting, we believe in rough consensus and running code.'' (Dave Clark)

''Rough consensus'' dagegen, der breite, wenn auch nicht einhellige Konsens, gilt als relativ immun gegen die Korruptionsanfälligkeit politischer Macht. ''The Internet way of doing things'' wird daher als eine Art Garant für die Qualität der Standards betrachtet, die in der IETF entwickelt werden. Seine Regeln sollten nach Überzeugung vieler in der IETF auch die Entscheidung über die nächste Generation von IP leiten.

Der Streit um die Vorherrschaft über die Addreß- und Namensräume des Internet zeugt von den sich ausdehnenden Reibungsflächen zwischen dem dezentralen, bislang weitgehend sich selbst überlassenen Netz und seiner vergleichsweise hoch regulierten gesellschaftlichen Umgebung. Das Internet wird zum Schauplatz eines Ringens um politische, wirtschaftliche und moralische Einflußsphären, in dem es allenfalls beiläufig um das geht, was bei den Konflikten über die Zukunft des Internet Protocols im Vordergrund stand: die Verständigung über die Eigenschaften der guten Netzarchitektur.

So lange IPv411 oder ein ihm verwandtes Protokoll wie IPv6 die regierende Technik im Internet bilden, wird sich an der Unregierbarkeit des Internets vermutlich wenig ändern. Denn auch ein von Grund auf neues, außerhalb der IETF entwickeltes Übertragungsprotokoll wird sich bestenfalls in Koexistenz, nicht aber als Alternative zu IP etablieren können.

Der Datenraum - Internet

Die Frage "Bist Du am Internet ?", die eigentlich "Bist Du mit dem Internet verbunden ?" heißen müßte, ist meist eine einfach zu beantworten, kann jedoch sehr unterschiedliche Dinge meinen. Erstens wenn der Computer über den gesprochen wird, über Modem ins Internet einwählt, so kann er nur eine beschränkte Anzahl von Diensten benutzen. Um alle Dienste zu nutzen ist es notwendig eine permanente TCP/IP-Verbindung12 zu besitzen, das heißt der Computer weiß wie er jeden anderen Computer im Internet kontaktieren kann und kann auch von jeden computer immer erreicht werden, um damit auch permanenter Teil des Internet zu werden.

Wenn man jedoch über ein Modem (Telefon) zum Internet verbunden ist, so bedeutet das, daß man mit einem Computer Kontakt hat, der über TCP/IP ein Teil des Internets ist.

Allein diese Eigenschaft macht die Strukturierung des Internets aus, denn daraus ergeben sich die Machtverhältnisse im Internet mit den sogenannten Internetanbieter (Provider), das sich nicht zuletzt nur finanziell auswirkt.

Funktion des Internets

Das Internet funktioniert auf Basis von Vereinbarungen, wie ein Datentransfer stattfindet.

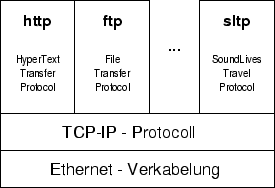

Diese Vereinbarungen sind in Schichten eingeteilt (siehe Abbildung 1, wobei die untersten Schichten nur für den Transport von Datenpacketen aller Art zwischen beliebigen Computern die im Internet zuständig sind und die oberen Schichten sogenannte Transfer Protokolle darstellen, die angeben wie diese Datenpackte verwertet werden können.

Das wohl bekannteste ist das HyperText Transfer Protocol. Als "http-Protokoll" wird es oft als quasi Universalprotokoll ausgegeben. Es bildet die Grundlage von WWW (World Wide Web) und wird oft mit dem Begriff "Internet" belegt. Daß dies jedoch nur ganz bestimmte Dinge zuläßt und den entsprechenden Regeln unterliegt wird meist vergessen. Es wurde erfunden, um Information abrufbereit und medien-wirksam aufzubereitet bereitzustellen und nur dazu.

Es waren im LAufe der Zeit immer mehr Erweiterungen notwendig das prinzipielle Manko des http-Protokolls, als reine Informationsbeschaffungs-Protokoll und nicht Informations-Mitgestaltungsfunktion zu umgehen, wie durch die Erweiterungen des Internetbraowsers ersichtlich ist (plugins).

Kunst im Internet - Netzwerkkunst

Der Einsatz von Kunst mit dem Netzwerk - ''Netzkunst'' ist am stärksten, wenn das Werk den Methoden der Netzwerktechnologien unterworfen ist und diese formt und nicht, wenn das Netzwerk als reine Präsentations-Methode zum Einsatz kommt - ''Kunst im Netz''. Die Bezeichnung Netzwerkkunst bezieht sich hier auf die Struktur und der Realisations-Methoden mit dem Netzwerk als Medium des Werkes. So der gängige Ansatz um die Begriffsverwirrung in diesen Bereich zu klären. Da jedoch der Begriff Kunst schon lange nicht mehr allein Innovation, Schaffen, usw. impliziert wird es wieder schwierig.

Als Hyposthese hier ein für das Netzkunstprojekt "The House of Sounds"13 gemachter Ansatz Protokolle selbst zu formen:

Beispiel des Entwurfs eines eigenen den Anforderungen genügenden Internetprotokolls

- Unikate

- Autonome Daten

- Kommunikation zwischen Daten

- ``Sterben`` von Daten

- Autonome Erzeugung von neuen Daten

- Wanderung von Daten

- Dynamische Entwicklung der Datenpfade im Internet

Regeln von Internetprotokollen können als Implementation eines Konzeptes und damit einer Ideologie des weltweiten Datentransfers und der Kommunikation betrachtet werden.

Da die bestehenden Protokolle wie http, smtp, ... nicht den Anforderungen genügte, wurde ein eigenes Protokoll (sltp, SoundLiveTravelProtokoll) implementiert.

Die wichtigsten Ansätze für SoundLives, Klangdaten die im Internet leben, werden im Folgendem mit jeweils einer Entsprechung im Internet diskutiert.

1]

#1

Autonome Daten

Daten können nur über ihre eigenen Regeln verändert werden, es kann nicht direkt auf ein Datum zugegriffen werden

Die Vorstellung, daß sich Daten selbst genügen, wurde Anlaß, Klangdaten mit zusätzlichen Informationen, in Form von Algorithmen mit eigener Syntax, auszurüsten, sodaß sie selbstständig im Datenraum (mittels des Verwaltungsprogramm) bewegen, entwickeln und kommunizieren können. Dies heißt, das Daten von Benutzern nicht verändert werden können und sie selbst Regeln besitzen14 wie sie sich verhalten und welche Information sie sammeln.

Die Verwendung von Klangmaterial als Datenelemente entstand wegen des intuitiv rezipierbaren Medium des Hören und wurden mit der Zeit um 3D-Grafiken erweitert.

Diese erweiterte Datenstruktur wurde SoundLive genannt.

Im sonstigen Programmen werden Daten mittels Editoren bearbeitet und können beliebig verändert werden.

Unikat

Jedes Datum besteht nur einmal zur gleichen Zeit am selben Ort

Durch diese Regel wird jeder Datensatz zur Entität und damit auch, mittels ID-Nummer und seinen Daten, zum Unikat. Dazu wurde im Protokoll des Netzwerkes und der Programme ein Duplizieren von SoundLive unterbunden und unmöglich gemacht.

Werden Daten kopiert sind sie nicht mehr in der Lage am diesem System teilzunehmen und damit ``weiterzuleben''.

Daten zeichnen ihre eigene Lebensgeschichte auf und bringen somit neue Information (z.B.: über besuchte Häuser) mit.

Diese Eigenschaft stellt sich im Gegensatz zum allgemein im Computern übliche Eigenschaft, daß alles kopiert werden kann und jeder Benutzer sich die Daten des einer Quelle dupliziert, wodurch die Redundanz der Information im Internet mit jeder Kopie steigt.

Interaktion zwischen Daten

Daten wird die Existenz anderer Daten mitgeteilt und diese können untereinader Information austauschen.

Allein die Präsenz von anderen Daten beeinflußt das Verhalten und den Klang des Datums. Dazu wurden Kommunikations-Mechanismen mit Erinnerungsvermögen installiert.

Dies steht im Gegensatz dazu, das Daten im selben Computer sich gegenseitig nicht beeinflussen außer über den Umweg des Benutzers.

``Sterben'' von Daten

Daten werden zyklisch abgefragt ob sie gelöscht werden wollen

Jedes Datum hat seine Geschichte, von der Geburt weg bis zu seinem ``Tod'', was durch eine Art Selbstlöschung geschieht (in diesem Fall besitzen sie unter anderem ein Maximalalter). Dies wurde mit einer dem Datum eigenen Funktion should_I_die() implementiert.

Hier geht es um das Prinzip des Löschens von Daten, denn zuviel Daten verbergen Information. Damit gibt es einen Entscheidungsträger ob Daten noch relevant sind.

Autonome Erzeugung von neuen Daten

Treffen sich Daten, erkennen ihre "Freundschaft" und die äußeren Bedingungen stimmen, können sie neue Daten erzeugen

Durch die Generierung neuer SoundLives mittels Vererbung von Teilen der jeweiligen Mutterdaten können neue Daten enstehen, welche sich kein Mensch direkt ausgedacht hat, indem es eine Verbindung verschiedener Merkmale vollzieht. Damit wird das Weiterbestehen des Systems gesichert und Querverbindungen von Inhalten geschaffen.

Der Benutzer ist nicht mehr zur Dateneingabe von Nöten, er kann aber auch nicht diese kontrollieren.

Wanderung von Daten

Das Datum bestimmt selbst wann und wohin es gesendet wird

Daten werden nicht wie üblich von anderen Computern geholt, sondern entscheiden sich selbst, welchen Pfad sie gehen wollen. Das dreht das Prinzip des normalen Datentransfers, z.B.: wie bei http, wo Daten immer gezielt geholt werden, um.

Der Benutzer wartet auf vorbeikommende neue Information. Damit kann Information zu ihm kommen die er nicht gezielt erwartet hat.

Dynamische Entwicklung der Datenpfade im Internet

Das Konzept ``the map of known world'', strukturiert die Kommunikation so, daß eine neues Haus nur seine Nachbarn kennt. Erst mit den eintreffen von SoundLives kommt auch die Nachricht über die Existenz anderer Häuser zu diesem Haus. Damit ergeben sich Datenpfade, die die Häuser verbinden und auf denen sich die SoundLives wieder neue Häuser suchen.

Es fällt das Aufsuchen und suchen neuer Adressen im Netz weg.

Man könnte hier noch viele Punkte anfügen, die jedoch den Rahmen dieser Information sprengen würde.15

About this document ...

Ort - NetzwerkThis document was generated using the LaTeX2HTML translator Version 99.1 release (March 30, 1999)

Copyright © 1993, 1994, 1995, 1996,

Nikos Drakos,

Computer Based Learning Unit, University of Leeds.

Copyright © 1997, 1998, 1999,

Ross Moore,

Mathematics Department, Macquarie University, Sydney.

The command line arguments were:

latex2html -split 3 netz_ort.tex

The translation was initiated by DI Winfried Ritsch on 2000-01-07

- Das Netz der Netze

- Wer regiert das Internet ?

- Organisationsform - Sebstorganisation ?

- Der Datenraum - Internet

- Kunst im Internet - Netzwerkkunst

DI Winfried Ritsch

2000-01-07